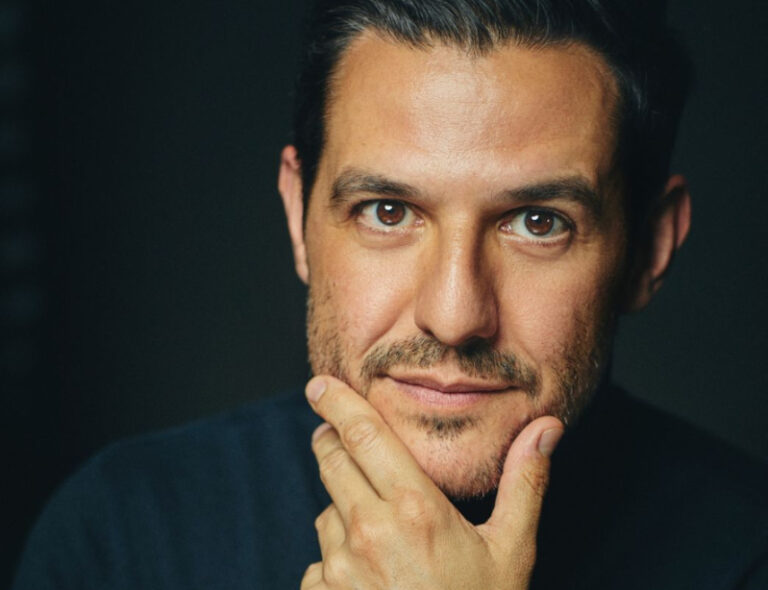

Roberto Carreras, CEO de Voikers y emprendedor pionero en el uso de voces sintéticas en el mundo del marketing y la comunicación digital, conversó con Ok-Bot by Convercom sobre la importancia que está teniendo la Inteligencia Artificial en la transformación del mercado del audio.

–¿Cómo estás viendo el crecimiento de los audios vinculados a la Inteligencia Artificial? ¿Qué cambios estás notando en la actualidad?

-Muchísimo. Al final lo que está propiciando a día de hoy la Inteligencia Artificial conversacional unida al audio es potenciarlo, a lo bestia. Hasta ahora para producir audios siempre necesitábamos un equipo técnico, un estudio de sonido, ingeniería, locutores, narradores, gente que sigue siendo necesaria, lógicamente, pero para grandes producciones. La tecnología de Inteligencia Artificial está llevando el audio adonde no se podía llevar por costes de inversión.

Pongo un ejemplo, escuchar artículos de periódicos en audio es algo que es tendencia hoy a nivel global. Bueno, eso se potencia gracias a que con voces sintéticas ese texto se puede transformar en audio en tiempo real. Calcula eso para cada día y por cientos de artículos que publica un medio de comunicación, sería impensable en el entorno tradicional. Con lo cual, gracias a esta tecnología, al final se logra que más gente consuma las noticias de un modo distinto.

Al final, el mundo del audio convencional y el mundo de la Inteligencia Artificial conversacional están muy relacionados uno y otro. Porque el audio o la tecnología de transcripción, por ejemplo, aplicada al audio, está posibilitando que a día de hoy podamos transcribir grandes cantidades de contenido de audio. Eso es muy importante de cara a lo que vamos a ver en los próximos años, porque hasta hoy un archivo de audio yo podía saber que era un MP3, pero lo que hay dentro no si no lo escuchabas. Puedo saber que un podcast se llama “Las noticias del día”, pero lo que dice dentro de él no. Puedo saber que un podcast trata de sostenibilidad, pero qué enfoque le da al tema no, para eso tenemos que escucharlos.

Ahora, gracias a la tecnología es posible transcribir esa información, cada vez ese proceso es más eficiente. Una vez transcrito, tenemos el audio cualificado como si fuese texto, con lo cual lo puedo buscar, puedo analizar temáticas, puedo aplicar procesando el lenguaje natural, para entender también entre todos los podcast de Argentina, por ejemplo, qué se dice, qué se habla.

Nosotros tenemos una herramienta de publicidad para podcasters, donde ellos nos dan información sobre su contenido, su audiencia, independientemente del lugar donde lo distribuyen y, al final, tenemos toda la información cualificada, de cara a los anunciantes. Les podemos decir, si quieren anunciarse en podcast de sostenibilidad, pues mirando aquí, aquí y allá… Eso, a día de hoy es un trabajo muy manual, pero nosotros ya estamos trabajando en aplicarle procesamiento de lenguaje natural, en aplicarle transcripción, en aplicar la Inteligencia Artificial, para tener la transcripción de todos los podcast que se publican en España y poder realmente cualificar el contenido.

O sea, hay muchas formas donde el audio y la tecnología de Inteligencia Artificial conversacional se están beneficiando unas a otras. Y está potenciando muchísimo, al final, el que el audio sea cada vez más accesible, cada vez más fácilmente producible, rastreable, como un formato muy líquido como lo ha sido el texto o el video durante mucho tiempo en Internet.

–¿Cuáles son según tu opinión los rubros que hoy se están beneficiando con estos avances?

-Creo que deberían ser todos, porque al final todos leemos, todos vemos y, cada vez más, todos escuchamos audio. Ya no es sólo un canal, un Spotify, son cada vez más canales. El audio es un formato que fluye muy bien: se comparte por WhatsApp, los jóvenes van hablando por la calle, escribimos los correos dictándolos… es algo que cada vez forma más parte de nuestra vida, ¿no?

Entonces hay más oferta, cada vez más demanda. Con lo cual no se debe abandonar. Le sirve a medios de comunicación para dar más visibilidad a su contenido, a compañías de todo tipo para generar un podcast, por ejemplo, que se pueda leer o escuchar.

Nosotros hacemos informes, memorias, presentaciones comerciales, presentaciones de formación, todo contenido que es interesante transformarlo en audio. Como consumidores cada vez tenemos menos tiempo y yo prefiero que una compañía me pase el informe en audio, porque lo voy a optimizar y me lo voy a escuchar mientras conduzco al trabajo, en el metro, en el autobús, mientras estoy sacando al perro o dando un paseo.

Hay muchos espacios ahora donde hay posibilidad de realizar una conexión muy íntima, de mucho valor y ahí el audio tiene un papel fundamental. Porque además, como consumidores de contenido, de entretenimiento o de formación, nos hemos acostumbrado mucho al on demand, consumir dónde, cuándo y cómo queremos. Eso es importante.

–Desde Voikers han trabajado con voces sintéticas. Hoy el alcance que tiene este desarrollo también abre debates con elogios y preguntas en torno al uso dañino que se les puede dar. ¿Cuál es tu opinión al respecto?

-Los veo muy necesarios. Dentro del mundo de lo que conocemos como voces creadas con inteligencia artificial es muy importante entender dos cosas. Por un lado, están las voces sintéticas, cuyo entrenamiento, es parecido al GPT y demás grandes modelos de procesamiento lenguaje. Son voces que parten de datos, no de humanos. Por otro lado, está la clonación de voces, que en lugar de inspirarse en datos que no pertenecen a nadie, sí pertenecen a alguien porque parten de un actor, parten de un Voice Over, parten de un narrador, de un locutor o de cualquiera que quiera hacerlo. Ahí estamos entrenando a un modelo de inteligencia artificial a hablar como aquella persona.

El proceso es complejo. Generamos un corpus lingüístico, es decir, todo lo que vamos a enseñarle a hablar a ese modelo. No es lo mismo hablar de una empresa de salud que de una empresa cervecera, son palabras muy distintas. Entonces ese corpus se crea en función del caso de uso y son cientos de palabras.

Hemos llegado a tener un Excel de 22.000 filas. Entonces, ese corpus que se genera con unas 20 horas de grabación, se lleva a un estudio y un locutor, a quien le vamos a clonar la voz, lo graba. Luego todos esos datos, tanto la transcripción como la voz, se utilizan para entrenar un modelo de inteligencia artificial que es capaz de replicar la voz de ese humano.

Por un lado, tenemos claro que la síntesis de voz es crear voces sintéticas que no existen, tenemos claro que la clonación de voz es copiar la voz de alguien… pero a veces se pueden mezclar. Es decir, si yo tengo muchas voces clonadas, puedo generar voces nuevas. Es decir, parten de un humano, pero las he utilizado como si fuesen voces sintéticas para entrenar un nuevo modelo. Y aquí es donde está una gran polémica que ha surgido últimamente, por la mala praxis de muchas empresas.

Por ejemplo, hay una gran polémica en una plataforma de audiolibros estadounidense en la que los locutores sin saber lo que estaban haciendo, firmaban una cláusula en la que cedían su voz para entrenar modelos de Inteligencia Artificial. Aquí en España un montón de locutores fueron a un casting aparentemente para un videojuego pero el contrato les hacía ceder sus derechos para un asistente virtual, para entrenar la voz de un modelo de IA.

Entonces, respondiendo a tu pregunta, creo que al mercado, a las empresas tecnológicas no les vale todo, deben entender que hay una industria enorme que es la locución, el doblaje y demás. Y cuando quieran una voz, deben plantear la posibilidad a esa gente de ganar dinero.

-¿Cuáles son las tendencias que estás viendo en el sector de la producción de audio sintéticos?

-Se están haciendo realmente muchos usos desde el punto de vista del entretenimiento. Por ejemplo, en la última película de Top Gun a Val Kilmer se le pudo poner voz, él la había perdido por un cáncer de garganta y lo que hicieron fue usar muchas de sus grabaciones antiguas y se consiguió replicar la voz mediante Inteligencia Artificial.

Hay otro caso también, por ejemplo, Accenture hizo una acción con The Times y sintetizaron la voz de JFK [John Fitzgerald Kennedy] y así se pudo escuchar el discurso que iba a dar el día que lo asesinaron. O sea, hay muchas iniciativas. Para nosotros, en nuestro proyecto Auris.audio, lo más útil es llevar audio a aquellos lugares donde no se usa por costes.

Por ejemplo, en un story de Instagram que dura 24 horas, que es efímero, al final no merece la pena invertir en un locutor, pero de repente poder poner una voz que te cuesta poco con Inteligencia Artificial sí puede ser útil. También sirve para poder transformar cualquier texto de un artículo, de un post de un blog, de una newsletter, en algo que se pueda escuchar, porque estás diciendo “oye no todo el mundo lee” o “no todo el mundo le apetece leer en un momento concreto”.

En esos casos le damos la posibilidad de escucharlo. También estamos detectando usos en todo lo que tiene que ver con materiales de formación, se están transformando en audios esos contenidos para que, en lugar de estar todo el día sentado leyendo, te los puedas escuchar. También estamos detectando usos en videos corporativos. Si bien la voz final de un anuncio la da una persona, porque le pone mucha más emoción, todo el proceso previo se puede hacer con voces sintéticas.

Luego también las estamos usando para las típicas noticias corporativas. Imagínate las menciones que hay en medios de comunicación nacionales e internacionales de tu compañía. La gente ya tiene bastante con las reuniones, con su trabajo y no puede leerse, encima, las noticias del sector. Pero si las transformamos cada mañana en audio y, en lugar de la newsletter, enviamos el audio por Slack, por Teams o por Whatsapp, por donde sea que fluya, pues estamos haciendo con voz sintética algo más fácilmente consumible, ¿no?

Hay muchos usos y cada vez más, por una razón muy importante: porque las voces sintéticas tienen cada vez una mayor calidad. Eso hace claro que el resultado al final sea bueno, sea óptimo, y que no sean aquellas voces robóticas que la gente recuerda, aquellos vídeos pesados de YouTube. Por el contrario, ya tienen entonación, tienen una parte de intención y la experiencia de escucha no tiene nada que ver con lo que estábamos acostumbrados.

Hacé tu comentario