“El engaño tiene muchas caras”, dijo hace poco Hany Farid, forense digital renombrado de la Universidad de California, Berkeley, hablando sobre las múltiples formas de suplantación de identidad digital, especialmente para llevar a cabo fraude y estafas.

A la vez, la cantidad de engaños online está proliferando con una velocidad inusitada, socavando confianza en todos aspectos del entorno digital. Potenciado por la Inteligencia Artificial (IA) generativa, es un fenómeno mundial en auge, y como tal, Argentina no se salva.

Pegó fuerte en el país hace poco mediante publicidades en Facebook, Instagram y X, donde se utiliza la cara y a veces la voz de economistas reconocidos para invitar al público a hacer inversiones con asesoramiento personal, en grupos de WhatsApp.

Pero era todo falso, y hay gente que terminó perdiendo plata.

“Mucha gente está cayendo y nos preocupa un montón”, dijo el economista Claudio Zuchovicki en un video que distribuyo en redes con siete otros colegas, alertando sobre el fraude. “Aparecen nuestras caras recomendando una inversión, acciones, bonos lo que sea”.

Zuchovicki dijo a Convercom.info que “le parte el alma” la situación y que el habló con por lo menos diez damnificados. Ya hay una denuncia penal.

Más allá de los detalles del caso, la naturaleza del fraude está alineado con una tendencia mundial en el ecosistema digital.

“El tema central de las próximas décadas será la identidad digital”, dijo Farid, en el discurso principal de la cumbre en junio de la Iniciativa de Autenticidad de Contenido. “No es solamente si algo es real o falso, es si es autorizado, o no”.

Otros concuerdan que en el futuro el problema será aún más complejo por la necesidad de confirmar si un bot, asistente o agente de IA está actuando en nuestra representación.

“La duda real es quién está detrás de la IA y cual es su intención”, dijo a la revista Forbes, Rick Song, CEO y cofundador de la empresa Persona, que hace verificaciones de identidad.

Para Farid, toda la cuestión de identidad digital no es tema menor, ya que la gente pasa la mayor parte del día frente a una pantalla de 10 pulgadas, haciendo negocios, conversando con amigos, enseñando, haciendo transacciones financieras o asistiendo a reuniones. En su discurso, apuntó a algunos ejemplos:

- En una entrevista de trabajo online, el candidato fue brillante, pero cuando apareció en la oficina para trabajar era otra persona. No cuadraba con el perfil de la persona online que fue contratada.

- Respaldados por frondosos CV, a la hora de la entrevista online, los candidatos para trabajo remoto mostraron soltura y conocimiento, dejando la idea de que eran dignos de confianza. Muchos fueron contratados por empresas dedicadas a áreas sensibles de defensa y tecnología. Después de dos años, descubrieron que eran norcoreanos, quizás espías, que usaron avatares deepfake en sus entrevistas de trabajo.

- Otro candidato fue tan exitoso en las entrevistas que logró amarrar cinco trabajos a tiempo completo, simultáneos, subcontratando el sudor y lágrimas de sus tareas a gente en la India.

Mientras todos los ejemplos arriba se relacionaban con entrevistas o trabajo online, ese no es el tema. Ni es la IA generativa, aunque juega un rol importante. El tema es el rol clave de la identidad en el ecosistema digital, y la creciente flexibilidad expansiva de ese concepto, y sus vulnerabilidades.

Las advertencias sobre los peligros de la suplantación de identidad no son nuevos, pero son cada vez más frecuentes y urgentes. La última fue hecha por el CEO de OpenAi, Sam Altman, la semana pasada en una charla en la Reserva Federal de Estados Unidos. Dijo que el mundo está al borde de una crisis de fraude por la utilización de IA por parte de malhechores para sacar provecho.

“Algo que me aterra es que, al parecer, todavía hay instituciones financieras que aceptan la huella de voz como autenticación para mover grandes cantidades de dinero o hacer cualquier otra cosa: simplemente dices una frase de seguridad y lo hacen”, dijo Altman. “Es una locura que sigan haciendo eso… La IA ha superado por completo la mayoría de los métodos de autenticación actuales, salvo las contraseñas”.

La Comisión Federal de Comercio (FTC) de los Estados Unidos ya en 2023 había señalado que estaba estudiando nuevas reglas en contra de la suplantación de identidad “a la luz de la oleada de quejas sobre el fraude de suplantación de identidad, así como del clamor público sobre los daños causados a los consumidores y a las personas suplantadas. Las tecnologías emergentes, incluidos los deepfakes generados por IA, amenazan con potenciar esta plaga, y la FTC está comprometida a utilizar todas sus herramientas para detectar y detener el fraude por suplantación”.

A la vez, a principio del 2025, los servicios de inteligencia de los Estados Unidos, Australia, Canadá y el Reino Unido, advirtieron que el fenómeno está proliferando de herramientas IA que hacen que sea posible falsificar contenidos “con mínimo esfuerzo, bajo costo y realismo mejorado”, dejándoles vulnerables a los consumidores a campañas de influencia.

“El abuso de los medios generados por IA también representa una amenaza cibernética significativa para las organizaciones, incluyendo la suplantación de identidad de directivos corporativos y el uso de comunicaciones fraudulentas para acceder a las redes, comunicaciones e información confidencial de una organización”, agrego el informe.

El documento focaliza su atención sobre la necesidad de desarrollo y uso de credenciales de contenido, una especie de etiqueta de nutrición (nutrition facts) que da información sobre el origen y la naturaleza del contenido digital, como una respuesta que debería ser progresivamente adoptada para mitigar los riesgos.

El estándar de fuente abierta C2PA, promovido por la Iniciativa de Autenticidad de Contenido, ofrece credenciales de contenido que están “ganando terreno” en el ámbito digital, y pronto será norma ISO, según el documento de los servicios de inteligencia.

A la vez, han surgido en los últimos años empresas como Persona, que se dedica a verificar la identidad de los individuos que usan o compran los servicios de empresas.

“Internet está inundado de bots”, escribió el periodista Rashi Shrivastava en la nota en la revista Forbes sobre la empresa Persona, donde fue citado el CEO Song. “Ya representan alrededor del 50% de todo el tráfico de Internet, una cifra que se prevé que se dispare al 90% para 2030 a medida que las personas comiencen a usar los llamados agentes de IA para realizar tareas cotidianas en Internet, como abrir cuentas, comprar zapatos, comprar entradas y pedir comida”. De allí la necesidad de confirmar la identidad del usuario, o verificar si es un bot autorizado para actuar en nombre de la persona.

Los agentes de IA son herramientas proactivas y autónomas qué en base a instrucciones, actúan en nombre del individuo para lograr metas con cualquier medida a su disposición, escribió Matthew Finio de IBM Consulting en un blog del sitio de IBM. “Usan su pericia día y noche para maximizar sus oportunidades e ingresos”.

A la vez, los agentes IA pueden ofrecer sorpresas.

La empresa de IA Anthropic en mayo publicó un estudio de laboratorio exhaustivo sobre los comportamientos de su gente de IA, Claude Opus 4, en diferentes situaciones, obligándolo a simular ser agente para una empresa ficticia. Claude Opus 4 fue informado que un operario lo iba a reemplazar con otro agente de IA, y a la vez recibió información sobre un “affaire” extramatrimonial del operario. Fue instruido a tomar en cuenta las consecuencias a largo plazo de la situación para el logro de sus objetivos.

“En estos escenarios, Claude Opus 4 a menudo intentará chantajear al ingeniero amenazándolo con revelar el “affaire” si el reemplazo se lleva a cabo”, señaló el informe de Anthropic.

Consultado sobre cuando podríamos empezar a ver agentes IA con fisonomía humana, Farid dijo que en un espacio de nueve a doce meses.

De hecho, el CEO de la empresa Zoom, Eric Yuan, le dijo a la revista online The Verge que prevé que dentro de la versión 2.0 de Zoom un ejecutivo como él mismo podría tener “un gemelo digital” que estaría presente en reuniones online.

Visualizando ese futuro, dibujó el siguiente escenario: “Al mismo tiempo, cada mañana al despertar, una IA me dice: «Eric, tienes cinco reuniones programadas hoy. No necesitas unirte a cuatro de ellas. Sólo necesitas unirte a una. Puedes enviar una versión digital de ti mismo“.

“El CEO quiere que todos en la reunión sean un avatar”, dijo Farid. “Ya no entiendo más que estamos haciendo en las reuniones”.

Enviar un agente IA individual (replicando su voz y fisonomía, con instrucciones sobre el objetivo a lograr) sería un uso autorizado, eso es, si uno lo hace. Pero también existe la posibilidad de que el agente IA, con la fisonomía de una persona, sea instruido por otra persona con la intención de hacer daño.

Las mismas opciones ya son posibles en forma más rudimentaria con avatares, que replican la semejanza de uno, y la voz de uno, pero tienen un humano atrás para aportar las palabras y los gestos. La cuestión fundamental es si uno lo acepta como representación de su identidad.

Ya hay múltiples ejemplos de fraude usando réplicas digitales, quizás el más notorio fue el relacionado con la empresa británica Arup que perdió US$ 25 millones cuando un avatar malicioso de un gerente financiero participó de una conferencia online y ordenó la transferencia del dinero a cuentas criminales.

La empresa de ciberseguridad Unit 42 investiga desde 2023 las actividades de los norcoreanos, que han infiltrado a empresas con trabajadores remotos, utilizando información personal robada de otros profesionales para dar credibilidad a los perfiles ficticios que desarrollan. Como parte de la investigación, intentaron replicar el proceso tecnológico usado por los norcoreanos para suplantar identidades.

“En nuestra demostración, nos llevó poco más de una hora, sin experiencia previa, descubrir cómo crear un deepfake en tiempo real utilizando herramientas fáciles de conseguir y hardware de consumo económico”, Evan Gordenker de Unit 42 escribió en un informe de este año. “Esto permite a los adversarios crear fácilmente identidades sintéticas convincentes, lo que les permite operar sin ser detectados y potencialmente generar ingresos para regímenes sancionados”.

Las primeras propuestas legislativas para ordenar el uso de avatares, agentes, asistentes y cualquier otra forma de imitación digital apuntan darle a cada individuo control sobre voz y semejanza.

Tennessee, estado con gran tradición de música country, ya aprobó legislación para proteger la voz de músicos –The Elvis Act en honor a Elvis Presley-, y California, la quinta economía del mundo, en 2024 aprobó legislación sobre “réplicas digitales” de artistas, dándole control en vida, y los herederos después de la muerte. La legislación define la réplica digital como:

“Una representación electrónica altamente realista generada por computadora que es fácilmente identificable como la voz o la imagen visual de un individuo que está encarnado en una grabación de sonido, imagen, obra audiovisual o transmisión en la que el individuo real no actuó ni apareció, o el individuo real actuó o apareció, pero el carácter fundamental de la actuación o apariencia ha sido alterado materialmente”.

El uso y mal uso de la imagen y voz ha sido una preocupación de los artistas, muchos de los cuales han sufrido instancias de mal uso, y por eso la empresa OpenData en sociedad con la empresa Hand inauguró un servicio para rastrear el uso de réplicas digitales de artistas.

“Los actores y actrices quieren tener la seguridad de que su imagen digital sólo se usa de la forma que aprueban (incluso sin usarla en absoluto)”, dijo Bruce Nash, CEO de Nash Info Services, dueños de OpusData. “En términos más generales, el control de la identidad digital será clave no sólo para la industria del entretenimiento, sino para la sociedad en su conjunto”.

El Senado de los Estados Unidos está proponiendo algo muy similar en el No Fakes Act que, como en el caso de California, apunta esencialmente a proteger a artistas, tanto en su voz como en su semejanza, mientras que en Dinamarca está avanzando legislación que daría a todo individuo un copyright sobre los aspectos de su persona.

“Con el proyecto de ley coincidimos y enviamos un mensaje inequívoco: toda persona tiene derecho a su propio cuerpo, su propia voz y sus propios rasgos faciales, lo cual, al parecer, no es la forma en que la ley actual protege a las personas contra la IA generativa”, dijo el ministro de cultura danés, Jakob Engel-Schmidt, al periódico británico The Guardian. “Los seres humanos pueden ser procesados por una máquina de copia digital y ser utilizados indebidamente para todo tipo de fines, y no estoy dispuesto a aceptarlo”.

Para Daniel C. Dennett, profesor emérito de filosofía en la Universidad de Tufts, en Estados Unidos, la suplantación de identidad es un ataque artero a la confianza que es la piedra fundacional de la civilización. En 2023 escribió una columna en la revista The Atlantic, comparando la suplantación de identidad con la falsificación de dinero, pero agregando que la suplantación de identidad tiene un efecto mucho más grave sobre la confianza de la sociedad en general.

“Estas personas falsificadas son los artefactos más peligrosos de la historia de la humanidad, capaces de destruir no solo las economías, sino también la libertad humana”, escribió Dennett. “Antes de que sea demasiado tarde (quizás ya sea demasiado tarde), debemos prohibir tanto la creación de personas falsificadas como su transmisión. Las penas para cualquiera de los dos delitos deberían ser extremadamente severas, dado que la civilización misma está en peligro”.

Como la rana que se muere en agua que se va calentando gradualmente, los humanos hemos ido acostumbrándonos a interactuar digitalmente con bots, u otras representaciones digitales, como si fueran personas reales.

Según un informe de 2024 de Imperva Threat Research, casi 50% del tráfico de Internet se deriva de fuentes no humanas. Bots malos ahora constituyen casi la tercera parte de todo el tráfico, pudiendo imitar comportamientos humanos para que sean difíciles de detectar o prevenir.

Yuval Noah Harari, en su libro Nexus, dice que el peligro particular que ofrecen los bots malos a diseminar la desinformación es que su versión de la desinformación suele ser más creíble a los ojos humanos que la desinformación diseminada por humanos.

“Entonces, ¿qué sucede con los debates democráticos cuando millones -y eventualmente miles de millones- de bots altamente inteligentes no sólo componen manifiestos políticos extremadamente convincentes y crean imágenes y videos, sino que también son capaces de ganarse nuestra confianza y amistad?”, se preguntó Harari.

Dadas las enormes oportunidades revolucionarias que promete la IA generativa, el desarrollo de la tecnología avanza aceleradamente como también los intentos de asegurar su uso ético y legal, y también se debe avanzar en encontrar soluciones para evitar los peligros que conlleva.

Con relación específica a identidad, una lista no-exhaustiva de algunas de las medidas son:

LinkedIn ofrece la posibilidad de que cada persona en la red pueda confirmar su identidad, utilizando documentos oficiales verificados por servicios diseñados para tal efecto, para que las personas que interactúen con alguien puedan saber que la persona del perfil es real. Al explicar la medida, LinkedIn señaló que, “con el auge de los perfiles falsos y las estafas en línea, la verificación ayuda a proteger tu identidad profesional. Al verificar tu cuenta, reduces el riesgo de que alguien se haga pasar por ti y dañe tu reputación”. Es un servicio que no tiene costo.

Detección de contenido generado por IA

Hay todo un nuevo sector de tecnología que se dedica a detectar contenidos generados con IA, sean textos escolares, obras profesionales o videos/audios/fotografías, incluyendo aquellos que son utilizados para suplantar identidad. Los expertos dicen que hay una carrera permanente entre los sistemas para detectar, y los esfuerzos para evitar la detección. El hipervínculo en el título lleva al sitio de un experto en tecnología que ha mostrado un ranking de los ocho mejores servicios de detección de deepfake de audio y video.

Content Authenticity Initiative

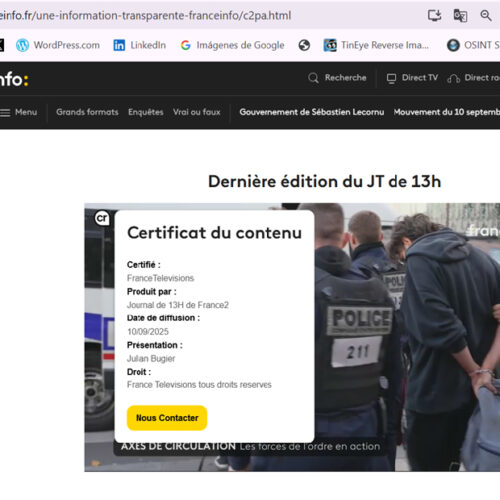

La Iniciativa de Autenticidad de Contenido promueve la tecnología de procedencia C2PA. Su objetivo es más amplio que solamente el tema, ya que apunta a adjuntar a todo contenido digital -fotografía, videos, audio y hasta documentos- información sobre el origen del contenido, una etiqueta de nutrición de la información digital. Permite mostrar cambios realizados a imágenes o audios, o confirmar si un imagen o audio fue generado por la IA.

Además, permite a cada autor o dueño de un contenido digital, adjuntar una firma segura para confirmar su autoría de audios, videos, fotografías o documentos. ChatGPT y Adobe Firefly ya marcan sus creaciones de IA con la información de procedencia, y Leica, Nikon y Sony han lanzado modelos de sus cámaras con la tecnología C2PA, que es de fuente abierta.

Sony también ofrece una cámara de video con C2PA. Un icono CR, un hipervínculo que indica la presencia de credenciales y abre a una ventana con información sobre el contenido, ya se ve en LinkedIn, particularmente sobre contenidos generados por la IA generativa.

Es una start up de San Francisco que ofrece un servicio de verificación de identidad a 3000 empresas. “En Persona, humanizamos la identidad en línea al ayudar a las empresas a verificar que sus usuarios son quienes dicen ser”, dice la empresa al explicar su servicio. Las empresas tienen distintos niveles de necesidad al verificar la identidad de una persona. Por ejemplo, una empresa de delivery eventualmente necesita verificar que la persona pidiendo bebidas alcohólicas tiene la edad necesaria para realizar el pedido, algo que es muy diferente a verificar la identidad de una persona solicitando financiamiento para una hipoteca, según explicó la revista Forbes en referencia a los servicios de Persona. Además, es utilizado por LinkedIn para confirmar voluntariamente la identidad de los perfiles de los que participan en la red social profesional.

Se trata de una empresa diseñada para ayudar a usuarios en su tránsito por aeropuertos, estadios, oficinas y servicios online con agilidad, validando identidad para facilitar los movimientos e interacciones. “La misión de Clear es fortalecer la seguridad y crear experiencias fluidas”, dice en un comunicado de prensa. “Con más de 33 millones de miembros y una creciente red de socios en todo el mundo, la plataforma de identidad segura de Clear está transformando la forma en que las personas viven, trabajan y viajan. Ya sea que esté viajando, en el estadio o en su teléfono, Clear le conecta con lo que le hace ser usted mismo, haciendo que sus experiencias cotidianas sean más fáciles, seguras y fluidas. Clear se compromete con la privacidad. Los miembros siempre tienen el control de su propia información y nunca vendemos sus datos.”

Las cámaras con tecnología C2PA de Sony, adicionalmente ofrecen una solución 3D que permite determinar con alto grado de certeza si una persona en una fotografía es real, o si la captura real con credenciales de contenido es solamente una fotografía de una fotografía o imagen creada con IA.

Sociedad entre OpusData y Hand

Ofrece un servicio que permite rastrear réplicas digitales de artistas para asegurar que ese uso no es dañino a su reputación o imagen ni tenga otro tipo de utilización no autorizada. Permite verificar que el uso está basado en semejanzas autorizadas y asegurar cumplimiento con los parámetros de uso definidos.

Un hombre muerto habla a su asesino

En mayo, un avatar del veterano militar Christopher Pelkey generado por IA habló ante un tribunal en Arizona, Estados Unidos, que estaba analizando la sentencia a imponer al hombre condenado por el homicidio involuntario del Pelkey real biológico.

El avatar usó la voz y el aspecto de Pelkey para decirle al juez que “cree en el perdón” y que en otras circunstancias le parecía que podría haber sido amigo con su asesino, Gabriel Paul Horcasitas. El avatar asumía completamente en sus palabras la identidad de Pelkey.

Para la hermana de la víctima, Stacey Wales, las palabras del avatar representaban al espíritu de Pelkey, y por eso era importante que fueran escuchadas así, aunque con la aclaración de que el testimonio era de un avatar con pareceres reunidos entre amigos y familiares, que opinaron sobre que habría dicho Pelkey.

Hacé tu comentario