Ya está disponible un arma muy potente con capacidad para cambiar el resultado de una elección, y no por las buenas.

A 14 meses de las elecciones presidenciales de Estados Unidos, el arma ya fue desplegada, y mientras la usan, los políticos están tomando medidas para limitarla (una contradicción típica de esa especie). En Argentina, a menos de dos meses de las elecciones presidenciales, el arma sigue en su funda, lista para ser utilizada en el momento crítico.

El peligro latente está a la vista, pero aquí se habla poco del tema. No hay propuestas públicas de medidas efectivas para contrarrestar el peligro.

¿Cuál es el arma? Es la Inteligencia Artificial (IA) generativa, que produce imágenes y sonidos realistas con sólo teclear unas palabras de instrucción.

¿Cuál es el peligro? Que a días de la elección circule en redes un video, grabación de voz o sencillamente una fotografía de gran realismo, pero falsa que comprometa a un candidato con algún ilícito o situación políticamente inaceptable.

No sería la primera operación para ensuciar con mentiras a un candidato a pocos días de una elección.

Quizás la maniobra tramposa más emblemática en el ámbito argentino fue cuando a pocos días de los comicios de 2005 el ex jefe del gobierno porteño Enrique Olivera y entonces candidato fue acusado, falsamente, de tener más de $2 millones de dólares en cuentas en el extranjero.

Pero hay una enorme distancia entre una acusación de terceros, y una imagen, video o grabación en la que un candidato se autoincrimine con una pieza de alto realismo cinematográfico pero contenido completamente falso.

“Aquí funcionan las formas más tradicionales de desinformación ¿Para qué invertir en sofisticación tecnológica?”, dijo a Convercom.info Adrián Pino, líder del proyecto Desconfío, una organización civil que lucha contra la desinformación.

Olivia Sohr, directora de Impacto y de nuevas iniciativas de Chequeado – principal organización de factchecking en Argentina, coincidió con Pino en su análisis. Dijo que hasta ahora la desinformación relacionada con la campaña electoral es mucho “más sencilla” y “más barata”. No obstante, Sohr visualiza un momento en el futuro cuando “los videos o las grabaciones van a dejar de ser prueba de que algo sucedió”.

En Estados Unidos, ya hay alertas sobre el tema y llamados a la acción. La sociedad civil Public Citizen, solicitó formalmente en julio a la Comisión Federal de Elecciones que clasifique el uso malicioso de la IA generativa como violación de la norma en contra de la “tergiversación fraudulenta”, es decir, fingir hablar en nombre de un candidato.

“Un deepfake, un video estilo blockbuster, de gran éxito, con este tipo de tergiversación fraudulenta, podría publicarse poco antes de unas elecciones, hacerse viral en las redes sociales y difundirse ampliamente sin que los votantes puedan determinar que sus afirmaciones son fraudulentas”, señalaron en la presentación.

Hablando de este escenario, el experto forense en desinformación Hany Farid dijo en una entrevista con el canal de noticias ABC que, lo que está en juego es la democracia.

“Hay un puñado de estados, un puñado de distritos en los que mover 50.000 votos en una dirección u otra, y eso puede cambiar el resultado”, dijo sobre los Estados Unidos, aunque lo mismo podría aplicarse en la Argentina donde hubo márgenes mínimos entre las tres principales fuerzas políticas en las PASO, algo que podría repetirse en las elecciones generales de octubre. “No queremos que unas elecciones se ganen o se pierdan basándose en un deepfake viral”, dijo Farid.

La IA generativa en política

En Estados Unidos, ya hay muchos ejemplos de la utilización de la IA generativa en la política.

En abril de este año el Partido Republicano publicó el primer video de campaña producido exclusivamente con IA. Tenía el título “Derrotar a Biden” y se refería al objetivo de los republicanos de derrotar al presumible candidato del Partido Demócrata, el actual presidente Joe Biden.

El vídeo, relatado con una voz en off, describe en imágenes, incluyendo imágenes sintéticas (producidas con IA) de Biden, un futuro distópico de miseria y caos si el actual presidente fuera reelegido en noviembre de 2024. Arriba, a la izquierda de la pantalla, incluye la notificación en letras grises apenas visibles: “Hecho íntegramente con imágenes de IA”.

El video abrió las puertas al uso de la IA para producir materiales de campaña. Pero los que le siguieron, muy pocas veces aclararon que fueron producidos con IA generativa.

En julio, un grupo político que apoya a Ron De Santis, el gobernador de Florida y precandidato para representar al Partido Republicano en las elecciones, lanzó un aviso que incluye una voz clonada de su rival, el expresidente Donald Trump, atacando a la gobernadora republicana de Iowa, un estado clave para las primarias presidenciales.

En mayo, el mismo grupo ya había producido un aviso sobre un discurso de De Santis, agregando con IA un desfile de aviones militares sobre el escenario del discurso, intentando fortalecer su reputación como líder fuerte y patriótico.

En junio una cuenta de Twitter asociada con el mismo candidato utilizó imágenes falsas mostrando al expresidente Trump abrazando al doctor Anthony Fauci, el histórico especialista en enfermedades que lideró el esfuerzo contra el Covid 19, muy criticado por los republicanos.

No todos los contenidos falsos tienen dueños conocidos. En marzo, un video falso circuló por Twitter (red social ahora rebautizada X). Tomado de un discurso de una senadora demócrata, cambió el texto para afirmar que las autoridades deberían quitarle el derecho al voto a los republicanos. Twitter/X luego dio de baja el posteo.

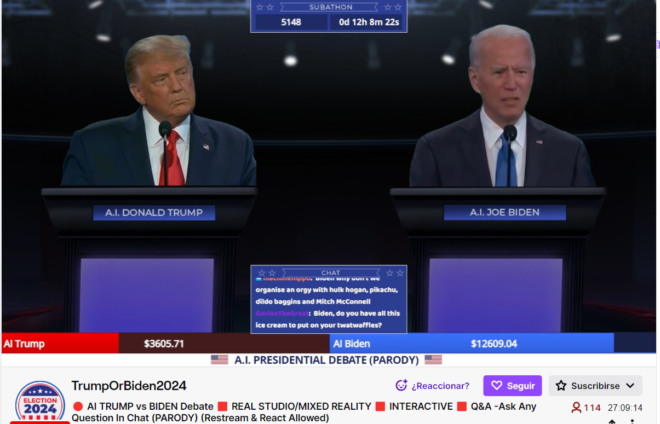

El poder de IA también se hizo claro en una parodia en Twitch que utilizó voz, texto e imagen, de un debate imaginario entre Trump y Biden, burdo y por momentos divertido.

Para los defensores de la libertad de expresión, ese uso era válido, primero, porque el video estaba claramente marcado como un producto de IA, y luego, porque también se anunciaba como una parodia. Al anunciarse de esa forma, el autor está avisando que no pretende hablar en nombre de los candidatos, ni publicar algo fáctico, sino hacer una obra de ficción con un comentario satírico sobre el estado de la política.

Un desafío para el factchecking

Según muchos expertos, los contenidos falsos generados con IA son un gran desafío para el factchecking tradicional ya que: primero, porque les cuesta a los chequeadores detectar como falsos aquellos contenidos que son generados por IA y; segundo, porque aún al detectar el origen del contenido, el daño ya habrá sido hecho.

Como dijo Ben Colman, CEO de Reality Defender, el contenido IA puede causar “daño irreversible” antes de que sea detectado. “Explicar a millones de usuarios que el contenido que ya vieron y compartieron fue falso, después del hecho, es demasiado poco, y demasiado tarde”, afirmó en una entrevista con NBCNews. Reality Defender es una empresa que vende un servicio para detectar contenidos generados con IA.

A mediados de agosto, un informe del Servicio de Investigación del Congreso (Congressional Research Service, CRS), un brazo oficial del Congreso estadounidense, afirmó que hasta ahora no hay una ley federal ni regulación que aborde el tema de la inteligencia artificial.

En el contexto de la auto regulación, la Asociación Americana de Consultores Políticos (AAPC, por sus siglas en inglés), condenó la utilización de deepfakes generados con IA generativa en campañas políticas y anunció a sus miembros que tomaría tal uso como “una violación fragrante” del Código de Ética de la entidad. “La junta directiva [de AAPC] acordó unánimemente que el uso de contenido deepfake de la IA generativa es una amenaza a la democracia que es dramáticamente diferente y peligrosa”, dijo la presidente de AAPC, R. Rebecca Donatelli.

Al nivel legislativo, hay una variedad de proyectos de ley sobre el tema. Entre ellos:

- El acta para avisos políticos reales, que obligaría que todo contenido político generado con IA lleve una etiqueta transparentando el origen. Una ley similar ya fue promulgada en el estado de Washington.

- El acta de fraude de voz del candidato, que prohíbe la inclusión en propaganda política discurso, generado por IA, simulando ser la voz de un candidato.

- Acta por la prevención de deepfakes representando imágenes intimas, que prohíbe la divulgación de contenidos que recreen imágenes íntimas; es una provisión general pero tiene penas agravadas por el uso prohibido en contexto electoral.

- El acta por divulgaciónde IA del 2023, que en términos generales requiere que cualquier contenido generado con IA lleve una etiqueta denunciando su origen.

Más allá de la posible legislación sobre el tema, hay mucho debate sobre cómo enfrentar al desafió en términos prácticos. Esto fue tratado en un muy amplio acuerdo voluntario en agosto entre la Casa Blanca y siete empresas de IA: Amazon, Anthropic, Google, Inflection, Meta, Microsoft y OpenAI.

En el punto específicamente relacionado con IA generativa acordaron: “Desarrollar e implantar mecanismos que permitan a los usuarios saber si los contenidos sonoros o visuales han sido generados por IA, incluyendo sistemas robustos de procedencia o de marcas de agua, o ambas cosas, para los contenidos sonoros o visuales generados por IA”.

Algunos servicios de IA generativa, como Dall-E, de Open AI ya usan marcas de agua (watermarks) visibles en imágenes para indicar su origen. Hay otras propuestas para marcas de agua invisibles al ojo humano, pero si detectables con medios tecnológicos.

Al analizar el acuerdo, Claire Leibowicz, líder del Partnership on AI -un esfuerzo multisectorial para definir parámetros para el uso responsable de contenidos sintéticos-, dijo que no está claro que las marcas de agua sean efectivas para limitar el uso malicioso de contenidos generados con IA generativa.

Entre otras cosas, Leibowicz dijo que es muy posible que las marcas de agua puedan ser eliminadas o fraguadas de tal forma que directamente no cumplan su propósito de identificar a los contenidos sintéticos.

La otra propuesta mencionada es de procedencia, o trazabilidad, que se lograría adjuntando etiquetas -como los octógonos usados para información nutricional- a los contenidos digitales. Las etiquetas darían información detallada al público sobre el origen de los contenidos, y los cambios realizados a los mismos en los procesos de edición.

La Iniciativa de Autenticidad de Contenido (Content Authenticity Initiative), con el apoyo de más de 1500 miembros en el mundo, lidera el esfuerzo principal para establecer un estándar mundial de procedencia que sea de fuente abierta. Con su brazo tecnológico, el grupo C2PA, la iniciativa ya desarrolló especificaciones técnicas.

Cualquiera que sea la opción elegida, hay algunas precondiciones para que las soluciones sean efectivas:

- Hay que asegurar que el público pueda entender correctamente el significado de la marca de agua o de la información de procedencia.

- En el caso de contenidos maliciosos, aclarar que son falsos después de que lleguen al público no es una buena opción. La confirmación de origen y autenticidad debe llegar junto al contenido.

- Deben tener un gancho para que, en caso de ser un contenido malicioso, las redes sociales y plataformas puedan aislarlo y limitar su difusión.

Ben Brooks, responsable de políticas de la empresa Stability AI, dio testimonio en junio sobre el tema en una sesión del Congreso de los Estados Unidos.

Respondiendo a una pregunta sobre si contenido sintético podría representar un riesgo para la realización de elecciones libres y justas, respondió que iniciativas como la propuesta de procedencia CAI son una parte importante de cómo lograr un ecosistema más robusto.

“No se trata solo de un problema de inteligencia artificial o de redes sociales”, dijo Brooks. “Va a requerir la participación de todo el mundo y la asunción de responsabilidades en todo el ecosistema”.

El autor de esta nota representa como consultor en América Latina a la Iniciativa de Autenticidad de Contenidos (Content Authenticity Initiative), mencionada en el texto. Este artículo no representa la opinión de dicha iniciativa.

Excelente nota !